감성 컴퓨팅(affective computing)은 컴퓨터가 인간의 감성과 감정을 인지하고 해석한 후 상황에 맞는 정보를 처리할 수 있도록 시스템을 개발하는 분야를 말한다. 컴퓨터공학, 인지심리학, 인간-컴퓨터 상호작용, 산업공학, 커뮤니케이션 등 다양한 분야에서 도입한 학문적 접근이다.

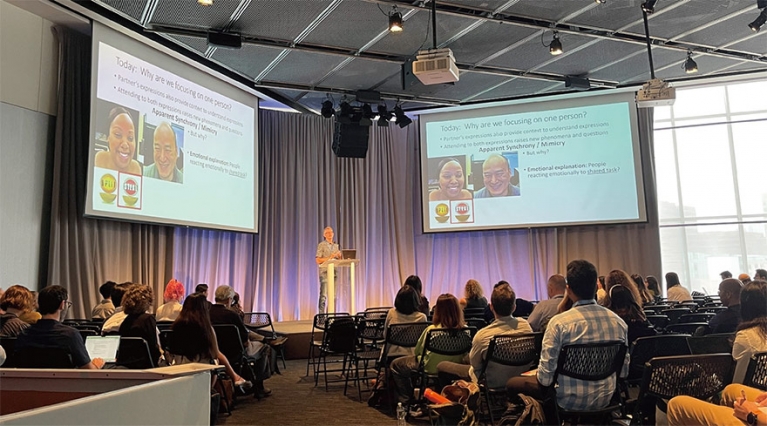

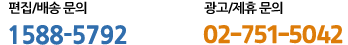

▎지난 9월 10~13일 미국 MIT에서 열린 ‘감성컴퓨팅+지능형 상호 작용’ 학회에서 서던캘리포니아대 창의기술연구소 소속 조너선 그래치 교수가 인공지능을 이용해 대화 중 표정의 싱크로율 인식에 대해 강연하고 있다. |

|

컴퓨터는 냉철하게 기계적인 계산만 하는 도구라는 기존 패러다임에서 벗어나 컴퓨터와 인간 사이에 감성적인 교류도 가능하다는 획기적인 인식의 변화는 1990년대 후반에 MIT 미디어랩 소속 컴퓨터공학자 로절린드 피카드(Rosalind Picard) 교수의 논문이 시발점이 되었다. 25년 가까이 흐른 2023년 현재, 감성 컴퓨팅 분야에는 어떤 변화들이 있었고 학자들은 어떤 화두를 두고 고민하고 있을까?9월 중순, MIT 미디어랩이 주최한 2023년 ‘감성 컴퓨팅+지능형 상호 작용’(Affective Computing+Intelligent Interaction) 학회에 기조연설자로 초청받아 참석할 기회가 주어졌다. 사흘간 이어진 학회에서 가장 뜨겁게 논의되었던 연구 주제들을 3가지 키워드로 정리하면, 맥락, 공감, 예측이 될 것 같다.

맥락(脈絡): 사물 따위가 서로 이어져 있는 관계나 연관

▎동 학회에서 조지아대 안선주 교수가 복합양식 확장현실(Multimodal Extensions of Realities)을 주제로 기조연설을 하고 있다. |

|

인공지능 등 시스템이 사물을 정확히 인식하거나 정보를 정확하게 처리하는 것은 생각보다 복잡한 일이다. 이 세상에 존재하는 모든 것은 서로 긴밀하게 연결되어 진공 상태에서 어떤 사물 하나만 단독으로 두고 판단할 수 없기 때문이다. 학회 발표에서 자주 등장하는 주제는 인공지능을 이용해 사람의 표정을 분석하는 문제였는데, 주요 인물을 제외한 배경을 지운 사진에서 인물의 잔뜩 찌푸린 표정만 컴퓨터에게 분석을 하라고 하면 부정적인 감정인 것으로 결과가 나온다. 그러나 올림픽 메달을 따게 된 배경을 사진에 추가하면 사람들은 그 찌푸린 표정이 사실 희열의 표현임을 바로 이해하지만 인공지능은 맥락을 읽어내지 못하고 여전히 부정적인 감정으로 인식한다. 이 문제를 해결하려면 컴퓨터가 인간의 복잡한 감정선과 서로 촘촘하게 연결되어 있는 사회문화적 사건들을 정확하게 분류하고 이해할 수 있어야 한다. 2023년 감성 컴퓨팅 학회에서 가장 주목해야 할 키워드는 맥락(context)이었다.기술 발전이 가속화되면서 곧 인공지능이 세상을 지배할 것 같지만 사실 맥락이 컴퓨터 시스템에 던지는 난제는 생각보다 효과적으로 풀기 어려워 전 세계의 내로라하는 많은 학자가 모여 고민하는 중이다. 지난 수십 년간 감성 컴퓨팅 분야가 집중했던 연구 주제는 인간의 표정이나 얼굴 근육의 움직임을 해부학적으로 분석하여 감정을 인식하고 분류하는, 비교적 협소하고 국지적인 문제였다. 그런데 얼굴 움직임 부호화 시스템(Facial Action Coding System)과 같은 기계적 분류에 의존하여 사람의 감정을 분석하는 것은 곧 한계가 드러났다. 같은 얼굴 근육들이 움직였어도, 그 사람이 어떤 행동을 하며 누구와 어떤 상황에서 그 표정을 지었나에 따라 완전히 다른 감정의 표현일 수도 있기 때문이다.인공지능까지 가지 않아도 사람들은 상대방이 처한 상황을 자세히 인지하지 못해 표정이나 눈빛만 보고 오해하는 경우를 살면서 자주 겪는다. 맥락에서 비롯되는 상황의 복잡함은 대략 다음과 같다. 나는 스스로의 상황을 알고 있지만, 상대방은 내 상황을 모르기 때문에 내 감정을 제대로 읽기 힘들다. 그런데 또, 상대방이 내 감정을 제대로 읽기 힘들다는 상황을 모르기 때문에 서로 오해를 하게 된다. 거대 언어 모델(large language model, LLM)을 이용한 감성 컴퓨팅 접근도 비슷한 난관들을 맞닥뜨리고 있다. 현재 학자들은 다양한 접근 방식으로 컴퓨터가 언어적ㆍ시각적 맥락을 인식하고 분류할 수 있도록 모델을 만들어나가고 있으며, 점점 시스템의 정확도가 올라가고 있지만 지금으로서는 한정된 맥락 안에서 인공지능을 이용해야 가장 정확한 결과를 도출할 수 있다.

공감(共感): 대상을 이해하거나 대상의 기분을 비슷하게 경험하는 심적 현상여러 세션에서 발표되어 눈에 띄었던 다른 키워드는 공감(empathy)이다. 그런데 앞서 맥락이라는 키워드는 인공지능 알고리즘에 미묘한 상황들 사이의 관계와 복잡함을 어떻게 가르칠지를 고민했던 것과 달리, 공감에 대한 발표들은 거꾸로 인공지능을 이용해 사람들이 서로 공감을 더 잘할 수 있도록 훈련하는 시스템을 솔루션으로 제시했다. 특히 헬스케어 분야에 적용할 수 있는 사례가 많았는데, 인공지능 시스템을 이용해 환자-의료진 간 커뮤니케이션을 돕는 연구들이 흥미롭다.대부분의 의료진은 환자와 그 가족들에게 청천벽력 같은 소식을 전해야 할 때가 많다. 또 비상 상황이나 정신없이 바쁜 스케줄 속에서 일일이 모든 환자에게 공감을 표현하는 것이 현실적으로 어렵거나 불가능한 경우도 많다. 특히 시한부 환자를 자주 접하는 의료진은 이 사실을 환자와 가족에게 어떤 말과 표정으로 전해야 할지 난감하게 느낄 수 있다. 이런 상황들에 대비해 의료진과 헬스케어 종사자들이 집이나 사무실, 혹은 의대 수업에서 인공지능 시스템을 활용해 연습하고 훈련할 수 있는 방법들이 제시됐다. 가령 암 환자에게 시한부 판정을 해야 하는 상황에서 환자와 대화를 나누는 시나리오를 띄우면, 실제 환자를 모델로 한 디지털 휴먼이 시한부 소식을 듣고 울음을 터뜨리는 등 현실과 흡사한 환자 역할을 하고, 컴퓨터 카메라를 켠 상태로 의료진은 그 상황에서 환자와 공감하며 어려운 상황에 힘을 실어줄 수 있는 대화 방식을 배우고 연습한다. 연습 세션이 진행되면서 실시간으로 인공지능이 의료진의 표정과 대화 내용을 인식한 후 평가하는데, 반드시 고쳐야 할 부분이 발생하면 바로 유저에게 시그널을 보내 더욱 집중적으로 훈련할 수 있도록 한다. 사람과 사람 사이의 공감이 점점 사라지는 시대에, 아이러니하게도 컴퓨터가 사람에게 공감을 가르쳐주고 있다.

예측(豫測): 미리 헤아려 짐작함마지막 키워드는 예측이다. 특히 인공지능을 활용해 사람들의 언어적ㆍ비언어적 커뮤니케이션 요소들을 인식하고 분석하는 과정을 자동화해 아직 발현되지 않은 질병도 잡아낼 수 있다는 말에 많은 연구진이 흥분했다. 증가 추세인 소아 자폐스펙트럼장애(Autism Spectrum Disorder, ASD)나 외상후스트레스 장애(Post Traumatic Stress Disorder, PTSD), 조현병(schizophrenia) 등 여러 정신 질병에 대한 기존 데이터(예: 눈빛, 머리 움직임, 뇌 스캔)로 훈련된 모델들이 정확하게 아직 증상이 채 발현되지 않은 환자나 증상이 심해지기 직전 상태의 환자들을 예측하여 지목할 수 있다는 결과들이 발표됐다. 따라서 증상이 발현되고 진단을 위해 많은 의료기관과 의료진을 거쳐 치료에 이르기까지 너무 긴 시간이 걸려 그간 고통을 받아왔던 환자들과 가족들은 다급한 사후 치료보다 예방 및 사전에 충분히 준비된 치료 방식을 선택할 수 있는 미래가 곧 다가오고 있다.

※ 안선주 - 조지아대 첨단 컴퓨터-인간 생태계 센터(Center for Advanced Computer-Human ecosystems) 센터장이며 광고홍보학과 교수다. 가상현실, 증강현실 등 뉴미디어와 이용자 행동 변화에 대해 연구하고 있다. 특히 의료, 소비자심리학, 교육과 연계한 가상현실 응용프로그램을 개발해 대화형 디지털 미디어에 의사소통 및 사회적 상호작용이 어떻게 변화하는지를 집중 연구하고 있다. 2022년 초 TED talks에서 ‘일상생활에 가상현실 통합’이란 주제로 발표한 바 있다.