딥시크의 효율적인 AI 훈련 방식은 전력 소비 절감을 통해 데이터센터의 지속 가능성을 개선하고, 데이터 저장 및 메모리 수요를 증가시킬 가능성이 있다.

▎ 사진:엔비디아와 딥시크 로고. 로이터=연합뉴스 |

|

딥시크의 효율적인 AI 훈련이 알려지면서 AI 커뮤니티에서는 활발한 논의가 시작되고 관련 주가는 요동쳤다. 그러나 딥시크 개발 과정에서 이루어진 발전을 보고 충격을 받았다면 곤란하다. AI 훈련을 위한 컴퓨팅과 네트워킹, 메모리, 저장 관련 기술은 오래전부터 효율성을 개선하고 전력 소비량을 줄이는 방향으로 혁신을 이루어왔기 때문이다.이런 발전은 하드웨어와 소프트웨어 모두에서 계속될 것이고, 덕분에 데이터센터는 더 적은 전력으로 더 많은 작업을 해내게 될 것이다. 더불어 더 많은 기관과 조직이 AI 훈련을 수행할 수 있도록 장벽을 낮추어 동일한 데이터센터에서 더 많은 작업을 수행하는 동시에 디지털 저장·메모리 성장을 주도해 AI 훈련이 확대될 수 있도록 지원할 것이다.고용량 AI 작업을 수행할 미래의 데이터센터는 기가와트(GW)급 전력을 필요로 할 수 있기 때문에 데이터센터의 전력 소비 전망치도 상승하고 있다. 캘리포니아주 샌프란시스코 전체에서 사용하는 전력량 5.8GW에 육박할 수 있다는 의견도 있다. 데이터센터 한 개가 대도시 하나에 육박하는 전력을 사용할 수도 있다는 뜻이다. 이 때문에 데이터센터들은 재생가능 에너지원이나 모듈형 원자로 등 비재생 에너지원 모두를 이용해 자체적으로 전력을 생산할 방법을 찾고 있다.그런데 미래의 데이터센터들이 AI 훈련과 추론의 효율성을 높여 전력 소비의 증가세를 낮출 수 있다면 어떨까? 딥시크가 사용한 경제적인 AI 훈련법은 훈련에 대한 접근성을 높이고 에너지 사용량을 줄여 더 많은 훈련을 수행할 가능성을 보여준다.딥시크는 ‘전문가 혼합(Mixture of Experts)’ 아키텍처를 활용하여 다른 AI 모델에 비해 현저히 적은 자원으로 효율적인 훈련을 수행했다. 이 아키텍처에서는 특화된 하위 모델이 서로 다른 작업을 처리하며, 계산 부하를 효과적으로 분산하고 각 입력에 대해 해당 모델의 관련 부분만 활성화함으로써 대규모 컴퓨팅 파워와 데이터에 대한 필요성을 줄였다. 이에 더해 스마트 메모리 압축 기술과 가장 중요한 매개변수만 학습시키는 기법을 결합하여, 더 적은 하드웨어로 높은 성능을 달성하고 훈련 시간과 전력 소비를 낮추었다.

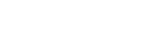

효율적인 AI훈련으로 투자수익 제고더욱 효율적인 AI 훈련은 적은 투자로 새로운 모델을 구축할 수 있게 하여 더 많은 기관이 AI 훈련을 수행하도록 도와준다. 학습 데이터가 압축되더라도 모델이 많아지면 학습에 필요한 데이터를 담기 위해 더 많은 저장 공간과 메모리가 필요하다. AI 훈련의 효율성이 높아질수록 AI로 인한 디지털 저장 수요도 증가하는 셈이다. AI 훈련에서는 앞으로 효율성의 추가 개선이 가능하다고 보기 때문에 AI 훈련의 방법론과 알고리즘이 딥시크를 넘어 더욱 발전하게 된다면 AI로 인한 향후 에너지 수요도 효과적으로 억제될 수 있다.데이터센터의 효율성을 확대하고 AI 구현에 필요한 투자의 효과성을 높이는 데 이는 매우 중요한 요건이며, 향후 AI 산업에서 투자 수익을 제고하는 데도 반드시 필요하다. 현재 진행 중인, 또 미래에 추진될 AI 훈련의 경제성 개선을 계속 달성·구현하는 데 실패하여 데이터센터의 전력 소비량이 전망치대로 증가하게 된다면, 지속가능성 노력은 위협을 받고 AI 발전을 가로막는 경제적 장벽이 생겨날지도 모른다. 그렇다면 데이터센터의 전력 소비 전망치가 어느 정도인지 데이터 저장장치의 전력 소비 전망을 함께 살펴보겠다.최근 미국 에너지부(Department of Energy)가 로렌스 버클리 국립연구소(Lawrence Berkeley National Laboratory)를 통해 발표한 보고서에는 2014년부터 2028년까지 미국의 데이터센터 전력 소비에 대한 역사적 추세와 전망치가 나와 있다. 보고서에 따르면, 전체 발전 에너지에서 데이터센터가 소비한 에너지 비율은 2018년까지 2% 미만으로 꽤 안정적으로 유지돼오다가 클라우드 컴퓨팅과 다양한 AI의 등장으로 2023년에는 전체의 4.4%로 증가했고, 이후 2028년에는 6.7~12.0%까지 증가하는 전망치를 보여준다. 이는 전력망에 심각한 압박으로 작용할 수도 있다.그런데 2018년에 이르는 기간을 살펴보면 컴퓨팅과 여타 데이터센터 활동이 증가하긴 했지만, 가상 머신과 컨테이너를 비롯한 아키텍처·소프트웨어 변화뿐 아니라 특수 목적 프로세싱이 부상함으로써 효율성이 크게 개선됐고, 동시에 새로운 스케일링과 네트워킹 기술 덕분에 데이터센터의 총전력소비량이 제한될 수 있었다.AI를 비롯해 여타 성장 중인 컴퓨팅 애플리케이션은 처리 데이터를 저장하기 위해 점점 더 많은 디지털 저장·메모리를 필요로 한다. 저장장치와 메모리는 전력을 필요로 하며, 에너지부 보고서에 따르면 2014년부터 2028년까지 전망되는 데이터센터 디지털 저장장치 에너지 소비량은 다음과 같다.

SSD 전력 소비 증가 전망시장조사 기관 IDC 정보를 기반으로 한 도표를 보면, 2018년부터 2028년까지 전력 소비량이 약 두 배가량 높아지는 전망을 볼 수 있다. 특히 낸드 플래시 기반 SSD의 전력 소비량 증가치 비중이 더 높아진다. 이는 데이터센터 애플리케이션에서 SSD 사용이 증가하기 때문이다. 즉, 높은 성능으로 인해 SSD가 주 저장장치로 사용되는 비중이 늘어나고 있기 때문이다. 그러나 대부분은 AI와 유사한 워크플로를 지원하기 위해 SSD 쓰기·읽기 작업이 더욱 집중적으로 이루어진다. SSD를 쓰고 읽는 작업은 SSD에 접근하지 않을 때와 비교해서 더 많은 에너지를 사용한다.HDD의 경우 즉각적으로 처리할 필요가 없는 데이터를 가지고 있기 위한 보조 저장장치로 사용이 늘어나고 있다. 장치가 증가 추세라 총저장용량은 계속 늘어나지만, 동시에 전력 효율성이 개선되고 있다. 따라서 2028년에는 데이터센터 저장장치를 위한 에너지 소비량의 절반 가까이는 SSD가 차지할 가능성이 있다.그러나 이들 추정치에서 저장장치·메모리를 위한 전력 소비량 증가는 AI 모델을 위한 GPU 프로세싱의 전력 소비량 증가보다 훨씬 적다. 메모리와 저장장치 풀링(pooling) 기술, 소프트웨어 관리에 기반한 저장장치·메모리 할당과 같은 새로운 기술은 AI 애플리케이션을 위한 저장장치·메모리 사용을 더욱 효율적으로 만들어줄 가능성이 높으며, 이는 AI 모델링의 효율성 또한 개선해줄 것이다.딥시크 등 AI 훈련의 효율성을 높인 접근법은 데이터센터의 전력 소비량을 줄이는 동시에 AI 모델링의 접근성을 확대하고 데이터 저장·메모리 수요를 증가시킬 가능성이 있다. 효율성이 지금보다 좋아질 수 있으며, 이는 결국 데이터센터의 지속가능성 개선으로 이어질 것이다.- Thomas Coughlin 포브스 기고자

위 기사의 원문은 http://forbes.com 에서 보실 수 있습니다.포브스 코리아 온라인 서비스는 포브스 본사와의 저작권 계약상 해외 기사의 전문보기가 제공되지 않습니다.이 점 양해해주시기 바랍니다.